OpenAIはAPI関連の料金が分かりにくい!

OpenAIのChatGPTや、DALL・E 2は非常に魅力的ですが、APIの使用料金についてはなかなか分かりにくくなっています。

また、Waitlistに登録しないといけないという点もあります。

そこで、今回はChatGPT,GPT-4などに関して利用料金がどのようなものかを調べてみました。

また、ChatGPT Plusを使わずにAPIを利用することで、よりお得に使える可能性についても下の方で考察しています。

じゃあ俺が金払ったChatGPT Plusって何だったんだよ?

本当にその通りですよね。こいつのせいでかなりややこしいと個人的に考えています。

まず、APIには料金が発生します。これは、従量課金性になっています。使った分だけ払う、というものですね。

では、ChatGPT Plusとは何なのか?

月20ドルのサブスクで、Web上でGPT-4を使うために必要になります。ではこれでGPT-4使えるんじゃないの?と言いたくなりますが、厳密には違うのです。

Web上の ChatGPTで、GPT-4を使うために必要になるのがChatGPT Plusなのです。 Web上のGPT-3.5 turboは無料で使えます。

これらは、Webで使うChatGPTのみの話なのです!

しかし、APIは全く別の扱いです。

なので、いくらサブスクに登録していたとしても、WaitlistでAPIが使えるようになるまでは待つ必要があり、料金も別口で請求されます。

しかし、Web上でOpenAIが提供するChatGPTは、ただ単にGPT-4,GPT-3.5 turboなどと繋がっているだけなのではなく、言葉での応答に関して最適化しているそうです。

よって、Web上で使っているChatGPTと、APIを通して使うChatGPT,GPT-4は、モノも利用料金も別物なのです!

また、GPT-4をWeb上で使うにはChatGPT Plusが必要になりますが、APIで使う分には必要ありません。

APIとして使う場合の料金はどうなるの??

Web上で利用する分には、GPT-3.5 turboは無料、GPT-4は月20ドルでした。

では、APIではどのように料金がかかるのでしょうか。これは、Web上のChatGPTとは異なり、単純ではありません。

まず、従量課金性です。 Twitter APIが有料になったのが懐かしいですが、あれは料金が最初から決まっている形式です。レートリミットの範囲内であれば、固定料金で使い放題です。

しかし、OpenAIのAPIは違います!

ある一つの基準で使用量が計算され、それに基づいて料金が請求されます。

その基準とは、tokenです。

このtokenはわかりやすく言うと、文章を意味ある所々で区切って一つのtokenとしています。

長い文章を入力すると、その分tokenは増えることになります。そのtokenの量をもとにどれほどリクエストを送信したかが計算されます。

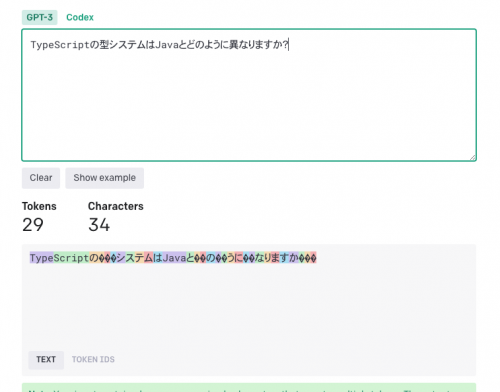

このtokenについてなんですが、日本語は非常に不利で、同じ意味の英文よりも日本語のほうがかなり多くのtokenがあると認識されます。

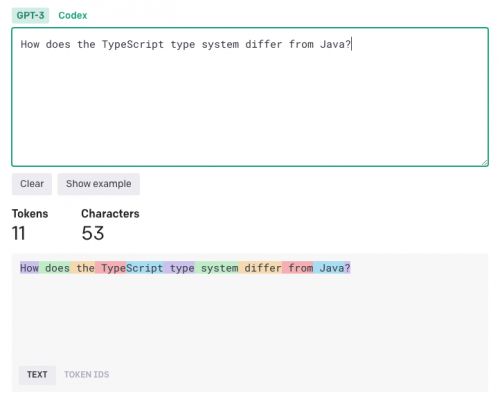

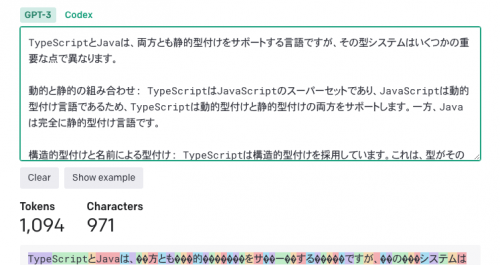

ChatGPTのtoken数に関して計算できるTokenizerというサイトを、APIを提供しているOpenAIが公開しています。

左のTokenという欄があります。これが、この文章をAPIを通して送信した時のToken数となります。

文字数は日本語の方が少なく、文章の意味も同じなのにToken数は約3倍です。 酷すぎます、、、。

また、GPT-4は返答のTokenも計算されます。日本語で返答してきたら、さらにToken数が爆増します!

これらTokenの合計によって料金が決定されます。

料金は、以下のようになっています。(2023/05/09 現在)

| モデル | プロンプト(こちらからの入力) | コンプレティション(APIからの返答) |

|---|---|---|

| GPT-4 8K context | 0.03 | 0.06 |

| GPT-4 32K context | 0.06 | 0.12 |

| GPT-3.5-turbo | 0.002 | – |

単位は、いずれも$/1K token(1000トークンあたりのドル)です。

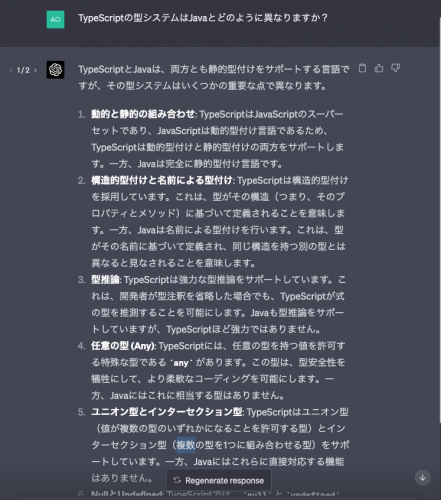

先ほどのTSとJavaのプロンプトに関して、それぞれTokenから料金を計算してみました。GPT-4を用いて、8k contextを利用します。

出力についてもTokenizerでTokenを求めます。

入力

29 token * 0.03$ / 1000token => 0.00087$

返答

1094 token * 0.06$ / 1000token => 0.06564$

合計

0.06651$(8.96円)

となりました。

一度の実行あたりだとそこまで大きな額とは思えませんね。

しかし、プログラムを入力したりなどすると、かなりのToken数になると予測されます。

GPT-3.5 turboを利用するという手もありますが、かなり精度が向上しているのでできればGPT-4を使いたいですよね。

ChatGPT Plus って損なの?

今自分たちでも皆が見える環境として、Slackのスレッド機能を用いてChatGPTを使えるようにするBotの制作を検討しています。APIが使えれば、WebのChatGPTのような機能を実装するのは予想より簡単です。すでに同じようなBotが多くあり、特にDiscordは公式の機能としてつけようとしているという話もあります。Microsoftと関係があるところは導入が特に早いです。Edge,Bingなどですね。

さて、ではWebのChatGPTを使わず、APIのみを通してGPT-4を使う場合の料金について考察してみました。

20ドルでどこまでできるか計算してみます。ここでは、GPT-4がどのような返答をするのかが未知数であるため、1応答あたりの合計Token数を1500として計算しています。かなり雑な計算になるので、ご参考程度にお願いします。

まず、入力と返答について料金が異なるので、平均してしまいます。(0.045$/1Ktoken)

入出力合計Token数(1500) * 平均価格(0.045$/1Ktoken) => 0.0675$(9.09円)

となりました。

20$で約296応答できることになります。

月296応答とすると、1日で9応答となります。

毎日使い続けるのは難しいと思うので、ちょっと多く見積もっても15応答となります。

となると、ちょっと物足りないかもしれませんね、、

まとめ

非常に分かりにくい料金体系ですが、非常に有用なことには変わりないです!積極的に使っていきましょう。

また、料金に関してはOpenAI自体最初はOpenだったのに関わらず、GPT-4に関してかなりの情報を非公開にしていることから、速いペースで変化していく可能性もあります。

料金について少しでも皆さんが知らなかったことをご説明できていたら嬉しいです。